SISTEMAS EXPERTOS

IntroducciónNuestro trabajo consta de cuatro partes:Historia y Definiciones del sistema experto; Generalmente los textos se organizan adaptanto una perspectiva histórica. En ellas se citan los problemas y soluciones más importantes que se han descubierto en el transcurso de su desarrollo.

Principales sistemas expertos y sus características; Al trasncurrir el tiempo, después del descubrimiento de I.A., se quería que los ordenadores sean capaces de ayudar al hombre, por ello surgen los primeros sistemas expertos, después de muchos intentos fallidos se logró construir los primeros sistemas expertos los cuales eran bastante complicados estos fueron: DENDRAL, MYCIN, XCON, etc.

Lenguajes de programación; Estos sistemas expertos fueron elaborados en lenguaje de programación especiales en su momento de descubiertos fueron considerados obsoletos.

Principales instituciones donde se investiga sistemas expertos en el Perú; Como sabemos vivimos en un mundo globalizado en la que es necesaria la tecnología y por ende el Perú esta tratando de integrarse a este mundo y por lo tanto tratando de investigar nuevos sistemas expertos.

Historia De Los Sistemas Expertos

Estas pensando que la

A comienzos de los años 50 el conocido Alan Mathinsong Turing publicó "Inteligencia y Funcionamiento de las Máquinas" con el fin de demostrar hasta que punto estas tienen inteligencia.

En estos años se dieron varias definiciones de lo que significaba la inteligencia en una máquina. Sobre lo que denominamos la inteligencia artificial.

Definición de Elaim Reich:La inteligencia artificial es el estudio de como hacer que los ordenadores hagan cosas que, en estos momentos, hace mejor el hombre.

Definición de Alexander Sporl (1971):

En su obra "Sporls-Computerbuch": Bajo Inteligencia entiendo la capacidad de un ser vivo o una máquina de ordenar informaciones, extensas observaciones, experiencias, descubrir interrelaciones para abstraer de esta forma cosas y poderlas ligar entre sí.

Uno de los primeros sistemas expertos se llamo Dendral y era capaz de calcular o descubrir hechos relativos a la estructura molecular a partir de unos datos químicos sin elaborar.Otro sistemas expertos famosos son MYCIN que diagnostica enfermedades de la sangre y que sugiere un tratamiento y PUFF, un sistema similar pero para enfermedades de pulmón.

En el año 1950 el campo de la automática recibe un gran impulso cuando Wiener desarrolla el principio de la retroalimentación. La teoría de la retroalimentación es base fundamental de los sistemas de control.

En 1955 Newell y Simon desarrollan la Teoría de la lógica. Este desarrollo permitió desarrollar un programa que exploraba la solución a un problema utilizando ramas y nudos, seleccionando únicamente las ramas que más parecían acercarse a la solución correcta del problema.

En 1956, se celebra una conferencia en Vermont (USA) de gran trascendencia en el desarrollo de la I.A. John McCarthy propone por primera vez el uso del término "Inteligencia Artificial" para denominar el estudio del tema.

En 1957, aparece la primera versión de "The General Problem Solver" (GPS, Solucionador general de problemas), un programa capaz de solucionar problemas de sentido común pero no problemas del mundo real como diagnósticos médicos. El GPS utilizaba la teoría de la retroalimentación de Wiener..

En 1958 McCarthy anuncia su nuevo desarrollo el lenguaje LISP (LISt Procesing), el lenguaje de elección para todos aquellos desarrolladores inmersos en el estudio de la IA.

En 1963, el Instituto Tecnológico de Massachussets (MIT) recibe una subvención de 2,2 millones de dólares del gobierno de los Estados Unidos en concepto de investigación en el campo de la IA. De esa forma, se comprueba la importancia que el Gobierno concede a la investigación dentro de ese campo.

En 1965 aparece DENDRAL, el primer sistema experto. Es en ese año cuando Feigenbaum entra a formar parte del departamento de informática de Stanford. Allí conoció a Joshua Lederberg, el cual quería averiguar cual era la estructura de las moléculas orgánicas completas. El objetivode DENDRAL fue estudiar un compuesto químico. El descubrimiento de la estructura global de un compuesto exigía buscar en un árbol las posibilidades, y por esta razón su nombre es DENDRAL que significa en griego "árbol".Antes de DENDRAL los químicos solo tenían una forma de resolver el problema, estar era tomar unas hipótesis relevantes como soluciones posibles, y someterlas a prueba comparándolas con los datos.

La realización de DENDRAL duró más de diez años (1965-1975). Se le puede considerar el primer sistema experto.

En 1965 también se empezaron a utilizar técnicas para la resolución de problemas que se caracterizaban por la búsqueda heurística como modelo para la resolución de problemas, y con ellas comenzó la investigación y desarrollo de los sistemas expertos.

En 1972, en la Universidad de Standford se desarrolla MYCIN, sistema experto dentro del campo de la medicina para diagnostico de enfermedades infecciosas en la sangre. MYCIN se trataba de un sistema experto para el diagnóstico de enfermedades infecciosas. Desde los resultados de análisis de sangre, cultivos bacterianos y demás datos, el prog rama era capaz de determinar, o en lo menos, sugerir el microorganismo que estaba causando la infección. Después de llegar a una conclusión, MYCIN prescribía una medicación que se adaptaba perfectamente a las características de la persona, tales como el peso corporal de este.

Al mismo tiempo, Davir Marr propone nuevas teorías sobre la capacidad de reconocimiento visual de las diferentes máquinas.

En 1972 aparece el lenguaje PROLOG basado en las teorías de Minsky.

En 1973 se desarrolla el sistema experto llamado TIERESIAS. El cometido de este sistema experto era el de servir de intérprete entre MYCIN y los especialistas que lo manejaban, a la hora introducir nuevos conocimientos en su base de datos. El especialista debía utilizar MYCIN de una forma normal, y cuando este cometiera un error en un diagnóstico (hecho producido por la falta o fallo de información en el árbol de desarrollo de teorías) TEIRESIAS corregiría dicho fallo destruyendo la regla si es falsa o ampliándola si es eso lo que se necesita.

En 1979 aparece XCON, primer programa que sale del laboratorio Su usuario fue la Digital Equipament Corporation (DEC).

El cometido de XCON sería configurar todos los ordenadores que saliesen de la DEC. El proyecto presentó resultados positivos y se empezó a trabajar en el proyecto más en serio en diciembre de 1978.

En abril de 1979 el equipo de investigación que lo había diseñado pensó que ya estaba preparado para salir, y fue entonces, cuando se hizo una prueba real, esperando resolver positivamente un 95% de las configuraciones, este porcentaje tal alto se quedó en un 20% al ser contrastado con la realidad; XCON volvió al laboratorio, donde fue revisado y a finales de ese mismo año funcionó con resultados positivos en la DEC.

En 1980 se instauró totalmente en DEC. Y en 1984, el XCOM había crecido hasta multiplicarse por diez. El XCOM supuso un ahorro de cuarenta millones de dólares al año para la DEC.

Entre los años 80 a 85 se produce la revolución de los Sistemas ExpertosEn estos 5 años se crearon diversos sistemas expertos como el DELTA, de General Electric Company, para la reparación de locomotoras diesel y eléctricas. "Aldo en Disco" para la reparación de calderas hidroestáticas giratorias usadas para la eliminación de bacterias.

Se crearon multitud de empresas dedicadas a los sistemas expertos como Teknowledge Inc., Carnegie Group, Symbolics, Lisp Machines Inc., Thinking Machines Corporation, Cognitive Systems Inc. formando una inversión total de 300 millones de dólares. Los productos más importantes que creaban estas nuevas compañías eran las "máquinas Lisp", que se trataba de unos ordenadores que ejecutaban programas LISP con la misma rapidez que en un ordenador central, y el otro producto fueron las "herramientas de desarrollo de sistemas expertos".

En 1987 XCON empieza a no ser rentable. Los técnicos de DEC tuvieron que actualizar XCOM rápidamente llegándose a gastar más de dos millones de dólares al año para mantenimiento y algo parecido ocurrió con el DELTA..También en 1987 aparecieron los microordenadores Apple y compatibles IBM con una potencia parecida a los LISP. El software se transfirió a máquinas convencionales utilizando el lenguaje "C" lo que acabó con el LISP.

A partir de los 90 y con el desarrollo de la informática, se produce un amplio desarrollo en el campo de la IA y los sistemas expertos, pudiéndose afirmar que estos se han convertido en una herramienta habitual en determinadas empresas en la actualidad.

La evolución histórica de los métodos utilizados en el desarrollo de los sistemas expertos también se ha producido a medida que se ha ido desarrollando la IA y los diferentes métodos que se han empleado para su resolución. El desarrollo de lenguajes como LISP y PROLOG condicionaron esa evolución, así como investigaciones en diversos campos relacionados. Los primeros sistemas expertos que se desarrollaron en los años 60 eran capaces de resolver solo problemas basados en situaciones determinadas, mediante sistemas de reglas .Es a partir de los 70 cuando se empiezan a resolver problemas basados en situaciones inciertas, basados en medidas difusas al principio y en redes probabilísticas con posterioridad.

Sus principales aplicaciones se dan en las gestiones empresariales debido a que;a) Casi todas las empresas disponen de un ordenador que realiza las

b) Este trabajo implica manejar grandes volúmenes de información y realizar operaciones numéricas para después tomar decisiones. Esto crea un terreno ideal para la implantación de los SE.

Además los SE también se aplican en la contabilidad en apartados como: Auditoria(es el campo en el que más aplicaciones de SE se esta realizando) Fiscalidad, planificación, análisis financiero y la contabilidad financiera.

ÁREAS DE APLICACIÓN

Los SE se aplican a una gran diversidad de campos y/o áreas. A continuación se listan algunas de las principales:

Militar

Informática

Telecomunicaciones

Química

Derecho

Aeronáutica

Geología

Arqueología

Agricultura

Electrónica

Transporte

Educación

Medicina

Industria

Finanzas y Gestión

VENTAJAS.-Estos programas proporcionan la capacidad de trabajar con grandes cantidades de información, que son uno de los grandes problemas que enfrenta el analista humano que puede afectar negativamente a la toma de decisiones pues el analista humano puede depurar datos que no considere relevantes, mientras un SE debido a su gran velocidad de proceso analiza toda la información incluyendo las no útiles para de esta manera aportar una decisión más sólida.

LIMITACIONES.-Es evidente que para actualizar se necesita de reprogramación de estos (tal vez este sea una de sus limitaciones más acentuadas) otra de sus limitaciones puede ser el elevado costo en dinero y tiempo, además que estos programas son poco flexibles a cambios y de difícil acceso a información no estructurada.

Debido a la escasez de expertos humanos en determinadas áreas, los SE pueden almacenar su conocimiento para cuando sea necesario poder aplicarlo. Así mismo los SE pueden ser utilizados por personas no especializadas para resolver problemas. Además si una persona utiliza con frecuencia un SE aprenderá de él.

Por otra parte la inteligencia artificial no ha podido desarrollar sistemas que sean capaces de resolver problemas de manera general, de aplicar el sentido común para resolver situaciones complejas ni de controlar situaciones ambiguas.

El futuro de los SE da vueltas por la cabeza de cada persona, siempre que el campo elegido tenga la necesidad y/o presencia de un experto para la obtención de cualquier tipo de beneficio.

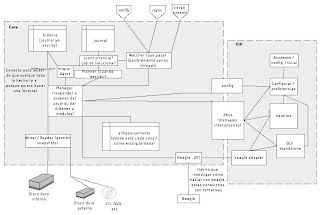

ARQUITECTURA BÁSICA DE LOS SISTEMAS EXPERTOS

Base de conocimientos. Es la parte del sistema experto que contiene el conocimiento sobre el dominio. hay que obtener el conocimiento del experto y codificarlo en la base de conocimientos. Una forma clásica de representar el conocimiento en un sistema experto son lar reglas. Una regla es una estructura condicional que relaciona lógicamente la información contenida en la parte del antecedente con otra información contenida en la parte del consecuente.

Base de hechos (Memoria de trabajo). Contiene los hechos sobre un problema que se han descubierto durante una consulta. Durante una consulta con el sistema experto, el usuario introduce la información del problema actual en la base de hechos. El sistema empareja esta información con el conocimiento disponible en la base de conocimientos para deducir nuevos hechos.

Motor de inferencia. El sistema experto modela el proceso de razonamiento humano con un módulo conocido como el motor de inferencia. Dicho motor de inferencia trabaja con la información contenida en la base de conocimientos y la base de hechos para deducir nuevos hechos. Contrasta los hechos particulares de la base de hechos con el conocimiento contenido en la base de conocimientos para obtener conclusiones acerca del problema.

Subsistema de explicación. Una característica de los sistemas expertos es su habilidad para explicar su razonamiento. Usando el módulo del subsistema de explicación, un sistema experto puede proporcionar una explicación al usuario de por qué está haciendo una pregunta y cómo ha llegado a una conclusión. Este módulo proporciona beneficios tanto al diseñador del sistema como al usuario. El diseñador puede usarlo para detectar errores y el usuario se beneficia de la transparencia del sistema.

Interfaz de usuario. La interacción entre un sistema experto y un usuario se realiza en lenguaje natural. También es altamente interactiva y sigue el patrón de la conversación entre seres humanos. Para conducir este proceso de manera aceptable para el usuario es especialmente importante el diseñodel interfaz de usuario. Un requerimiento básico del interfaz es la habilidad de hacer preguntas. Para obtener información fiable del usuario hay que poner especial cuidado en el diseño de las cuestiones. Esto puede requerir diseñar el interfaz usando menús o gráficos.

Lenguajes de programación

Son programas que se han diseñado principalmente para emular un comportamiento inteligente. Incluyen algoritmos de juego tales como el ajedrez, programas de comprensión del lenguaje natural, visión por computadora, robótica y "sistemas de expertos". responde a una interfaz ensamblador, el segundo a interfaz compilador y el ultimo a interfaz interprete.Un Lenguaje de Programación se basa en reglas de acción (silogismos) , y el análisis de posibilidades dándonos una ayuda muy útil en todas las ramas de la acción humana. Es así como los Sistemas Expertos desarrollan una Función muy importante "Realizar tareas genéricas: es decir para la monitorización y el diagnóstico, además de los trabajos de simulación de la realidad (Realidad Virtual en la actualidad) .

Algunos lenguajes son lenguajes principalmente interpretados, como APL, PROLOG y LISP. :

APL (A Programing Language)

Diseñado para tablas, vectores y matrices; utiliza símbolos especiales, distintos que el ASCII.

HISTORIA:Introducido por Kenneth Iverson, en el año de 1962. Durante los siguientes 7 años IBM trabajo en el APL, defino un conjunto de caracteres y un lenguaje "APL/360", el cual se requiere un hardware especial.Conceptos lisp:

· Listas y Átomos: La estructura más importante es la lista. Los átomos pueden subordinarse a cualidades.

· La Función: Cada función LISP y cada programa LISP tiene estructura de lista. Los programas no pueden distinguirse sintácticamente de los datos. LISP ofrece sus propias funciones básicas.

· Forma de Trabajo: LISP es un lenguaje funcional. Ofrece la posibilidad de realizar definiciones recursivas de funciones. La unión de procedimientos se realiza de forma dinámica, es decir en plena ejecución, y no como en otros lenguajes de programación. El sistema realiza automáticamente una gestión dinámica de memoria.

Entonces: La estructura más importante en LISP es la lista Componentes de un sistema lisp.

Un componente importante de un sistema LISP es la gestión dinámica de la memoria. El sistema administrará el espacio en la memoria para las listas en constante modificación, sin que el usuario lo deba solicitar. Libera los espacios de memoria que ya no son necesarios y los pone a disposición de usos posteriores. La necesidad de este proceso se deriva de la estructura básica de LISP, las listas, que se modifican de forma dinámica e ilimitada. Además un sistema LISP abarca bastante más que el solo intérprete del lenguaje LISP. Consta de algunos módulos que ofrecen ayuda en el desarrollo y control del progreso en programas, como son el Editor, el File-System y el Trace.PROLOGO (PROgramación LOGica):

Mecanismos Del Prolog

La Recursividad representa la estructura más importante en el desarrollo del programa. En la sintaxis del PROLOG no existen los bucles FOR ni los saltos; los bucles WHILE son de difícil incorporación, ya que las variables sólo pueden unificarse una sóla vez. La recursión es más apropiada que otras estructuras de desarrollo para procesar estructuras de datos recursivas como son las listas y destacan en estos casos por una representación más sencilla y de mayor claridad. La Instanciación es la unión de una variable a una constante o estructura. La variable ligada se comporta luego como una constante. La Verificación es el intento de derivar la estructura a comprobar de una pregunta desde la base de conocimientos, es decir, desde los hechos y reglas. Si es posible, la estructura es verdadera, en caso contrario es falsa. La Unificación es el componente principal de la verificación de estructuras. Una estructura estará comprobada cuando puede ser unificada con un hecho, o cuando puede unificarse con la cabecera de una regla y las estructuras del cuerpo de dicha regla pueden ser verificadas.

Rita, Rosie, Y Roos.

Para el desarrollo de los sistemas expertos se utilizan lenguajes de ingeniería del conocimiento. Los lenguajes más difundidos para el desarrollo de los SE son RITA, ROSIE, y ROOS.

Comenzaremos hablando de ROSIE, un lenguaje evolucionado de RITA. Este lenguaje permite al programador describir relaciones complejas y manipularlas simbólica y deductivamente. Además soporta trabajo en redes, trabaja en una forma Interactiva compilada e interpretada y cuenta con una serie de depuradores y herramientas de programación. Como puede ser programada en una sintaxis parecida al Ingles esto la hace bastante leíble y entendible para los usuarios. Este lenguaje integra dos paradigmas programáticos que lo hace especial: modelacimiento basado en reglas y procedure-oriented computing (al ser lenguajes secuenciales y al mismo tiempo orientados a objetos), y por último es que puede ser organizado como un programa LISP lo que la hace fácil de aprender.El lenguaje ROSS, es un lenguaje de programación orientado a objetos, y combina la Inteligencia Artificial y los Sistemas Expertos principalmente en el área de simulaciones. Entre sus ventajas se citan las facilidades para buscar entre objetos y su comportamiento. El programa se desarrolla de una forma que los objetos se comunican mandando mensajes para causar que las reglas o comportamientos apropiados sean ejecutados.

Se presenta en forma resumida dos Sistemas Expertos que fueron decisivos para el éxito del avance investigador en el campo de los Sistemas Expertos.

Mycin

Sistema Experto para diagnósticos médicos:

MYCIN es un Sistema Experto para la realización de diagnósticos, iniciado pro Ed Feigenbaum y posteriormente desarrollados por E.Shortliffe y sus colaboradores. Su función es la de aconsejar a los médicos en la investigación y determinación de diagnósticos en el campo de las enfermedades infecciosas de la sangre. El sistema MYCIN, al ser consultado por el médico, solicita primero datos generales sobre el paciente: nombre, edad, síntomas, etc. Una vez conocida esta información por parte del sistema, el Sistema Experto plantea unas hipótesis. Para poder verificarlas comprueba primero la exactitud de las premisas de la regla (Os preguntareis como hace esto). Esto se realiza mediante una búsqueda de enunciados correspondientes en la base de conocimientos. Estos enunciados pueden a su vez estar de nuevo en la parte de consulta de otra regla. También lo realiza mediante determinadas preguntas al usuario. Aquí se hacen preguntas del tipo: ¿Se ha practicado en el paciente algún tipo de intervención quirúrgica?

Con las respuestas que recibe, el MYCIN verifica o rechaza las hipótesis planteadas. Una serie de tests han demostrado que MYCIN trabaja igual de bien que un médico.( A mi particularmente me cuesta mucho creerlo y me parece que es increíble, pero ahí están los resultados de los test).

XcoN

Sistema Experto para configuración de Ordenadores:

XCON es un Sistema Experto para configuraciones desarrollado por la Digital Equipment Corporation. Según los deseos individuales del cliente se configuran redes de ordenadores VAX. Ya que el abanico de productos que se ofrecen en el mercado es muy amplio, la configuración completa y correcta de un sistema de estas características es un problema de gran complejidad. Las funciones de este Sistema Experto son las siguientes: ¿Pueden conjugarse los componentes solicitados por el cliente de forma conveniente y razonable?

¿Los componentes de sistema especificados son compatibles y completos?Las respuestas a estas preguntas son muy detalladas. XCON es capaz de comprobar y completar los pedidos entrantes mucho más rápido y mejor que las personas encargadas hasta ahora de esa laborTambién se han desarrollado Asesores Inteligentes para apoyar la enseñanza de programación, en distintos lugares y con distintas arquitecturas. Entre otros, podemos mencionar:

COACH (Cognitive Adaptive Computer Help):

Permite crear ayuda personalizada al usuario. Es un observador de las acciones del usuario que está aprendiendo a operar un ambiente, y en base a ellas construye un modelo adaptativo del usuario. Si bien el concepto general es aplicable para áreas diversas tales como las Interfases Inteligentes y el soporte técnico, en particular es de interés para este trabajo ya que los dominios de prueba que modeló corresponden al de un lenguaje y un entorno de programación (LISP y UNIX, respectivamente); así como por la prueba de adaptabilidad a distintos dominios en que probó ser efectivo. En dicha prueba, después de completar el desarrollo y pruebas del tutor bajo el dominio de LISP, se encargó a un estudiante inexperto, su adaptación al dominio de UNIX; dado el éxito de la adaptación, a pesar de la inexperiencia del constructor del dominio, Selker concluye que la aplicación de los conceptos y modelación del dominio son apropiados para diversos dominios, y por lo tanto, fácilmente adaptables.Una de las contribuciones importantes de Coach consiste en la descripción de diversos modelosde usuarios, representados por medio de frames adaptativos; y el modelado cognitivo de variables tales como la experiencia, la latencia del conocimiento. Por otro lado, el análisis de resultados que hace Selker, basado en el comportamiento registrado por los usuarios de sistemas tradicionales y los del sistema asesor, muestra variables cuantificables para medir el éxito de un sistema similar como el que ocupa este trabajo.

CONCLUSIONES

Actualmente el duro, difícil y cambiante mercado competitivo se vuelve más complejo por la gran diversidad de información que se ven obligados a almacenar y analizar, razón por la cual las empresas se ven en la necesidad de recurrir a poderosas y/o robustas herramientas o sistemas que les sirvan de soporte a la hora de tomar decisiones. De esta forma estos inteligentes, precisos y eficientes sistemas son adoptados por más organizaciones, en las cuales se convierten y/o transforman en una importante estrategia de negocio.

Por otra parte es importante mencionar que estos seguirán siendo usados en los todos y cada una de las áreas y/o campos donde los expertos humanos sean escasos. Por consecuencia de lo anterior estos sistemas son utilizados por personas no especializadas, por lo cual el uso frecuente de los (SE) les produce y/o genera conocimiento a los usuarios.

Bibliografía

www.dei.va.educpy\tar17\sexpreti\historia.htmwww.sarder.upeu.edu.pe\~miguel+\temas\expertos.htmwww.fotunecity.com\skycod.per\ronrow\207\se\portada.htmwww.monografias.com

INTELIGENCIA ARTIFICIAL

Él termino "inteligencia artificial" fue acuñado formalmente en 1956 durante la conferencia de Darthmounth, más para entonces ya se había estado trabajando en ello durante cinco años en los cuales se había propuesto muchas definiciones distintas que en ningún caso habían logrado ser aceptadas totalmente por la comunidad investigadora. La AI es una de las disciplinas más nuevas que junto con la genética moderna es el campo en que la mayoría de los científicos " más les gustaría trabajar".

Una de las grandes razones por la cuales se realiza el estudio de la IA es él poder aprender más acerca de nosotros mismos y a diferencia de la psicología y de la filosofía que también centran su estudio de la inteligencia, IA y sus esfuerzos por comprender este fenómeno están encaminados tanto a la construcción de entidades de inteligentes como su comprensión.

El estudio de la inteligencia es una de las disciplinas más antiguas, por más de 2000 años los filósofos no han escatimado esfuerzos por comprender como se ve, recuerda y razona junto con la forma en que estas actividades deberían realizarse. Según John Mc Carthy la inteligencia es la "capacidad que tiene el ser humano de adaptarse eficazmente al cambio de circunstancias mediante el uso de información sobre esos cambios", pero esta definición resulta muy amplia ya que de acuerdo con esta, el sistema inmunológico del cuerpo humanó resultaría inteligente ya que también mediante el uso de información este logra adaptarse al cambio. Otra interesante manera de ilustrar la inteligencia seria recurrir a la teoría societal de la mente de Marvin Minsky donde cada mente humana es el resultado del accionar de un comité de mentes de menor poder que conversan entre sí y combinan sus respectivas habilidades con el fin de resolver problemas.

La llegada de las computadoras a principios de los 50, permitió el abordaje sin especulación de estas facultades mentales mediante una autentica disciplina teórica experimental. Es a partir de esto que se encontró que la IA constituye algo mucho más complejo de lo que se pudo llegar a imaginar en principio ya que las ideas modernas que constituyen esta disciplina se caracterizan por su gran riqueza, sutileza e interés; en la actualidad la IA abarca una enorme cantidad de subcampos que van desde áreas de propósito general hasta tareas especificas.

Una de las definiciones que se han dado para describir la IA la sitúa dentro de una disciplina que tiene que ver con las ciencias de la computación que corresponden al esfuerzo por parte de gran cantidad de científicos que durante los últimos treinta años han realizado con el fin de dotar a las computadoras de inteligencia, a partir de esta definición encontramos que una de las técnicas de IA es aquella que se utiliza con el fin de lograr que un determinado programa se comporte de forma inteligente sin pretender tener en cuenta la " forma de razonamiento "empleada para lograr ese comportamiento.

Luego, aquí surge un dilema, ya que según esto cualquier problema resoluble por un computador, sin complicaciones y también como un ser humano podría encuadrarse en el campo de la inteligencia artificial acudiendo solamente a la aplicación de reglas consecutivas al pie de la letra o lo que encontramos con el nombre de Algoritmos dentro del lenguaje de IA; este termino fue acuñado en honor al matemático árabe AL-KWARIZMI que copiló una serie de estos para ser aplicados a diferentes problemas algebraicos.

Cuando se aplican algoritmos a la solución de los problemas aunque no se está actuando inteligentemente si esta siendo eficaz pero los problemas realmente complicados a los que se enfrenta el ser humano son aquellos en los cuales no existe algoritmo conocido así que surgen de reglas que tratan de orientarnos hacia las soluciones llamadas Heurísticas en las cuales nunca nada nos garantiza que la aplicación de una de estas reglas nos acerque a la solución como ocurre con los anteriores.

A partir de estos datos; Farid Fleifel Tapia describe a la IA como: "la rama de la ciencia de la computación que estudia la resolución de problemas no algorítmicos mediante el uso de cualquier técnica de computación disponible, sin tener en cuenta la forma de razonamiento subyacente a los métodos que se apliquen para lograr esa resolución.

Para completar esa definición, algunas definiciones no tan formales emitidas por diferentes investigadores de la IA que consideran otros puntos de vista son:

o La IA es el artede crear maquinas con capacidad de realizar funciones que realizadas por personas requieren de inteligencia. ( Kurzweil, 1990)

o La IA es el estudio de cómo lograr que las computadoras realicen tareas que, por el momento, los humanos hacen mejor. (Rich, Knight, 1991).

o La IA es la rama de la ciencia de la computación que se ocupa de la automatización de la conducta inteligente. (Lugar y Stubblefied, 1993).

o La IA es el campo de estudio que se enfoca a la explicación y emulación de la conducta inteligente en función de procesos computacionales. (Schalkoff, 1990).

En la IA se puede observar dos enfoques diferentes:

1. La IA concebida como el intento por desarrollar una tecnología capaz de proveer al ordenador capacidades de razonamiento similares a los de la inteligencia humana.

2. La IA en su concepción como investigación relativa a los mecanismos de la inteligencia humana que se emplean en la simulación de validación de teorías.

El primer enfoque se centra en la utilidad y no en el método como veíamos anteriormente con los algoritmos, los temas claves de este enfoque son la representación y gestión de conocimiento, sus autores más representativos son McCrrthy y Minsky.

En el segundo enfoque encontramos que este se orienta a la creación de un sistema artificial capaz de realizar procesos cognitivos humanos haciendo importante ya no la utilidad como el método, los aspectos fundamentales de este enfoque se refieren al aprendizaje y adaptabiliada y sus autores son Newell y Simon de la Carnegie Mellon University.

La IA al tratar de construir maquinas que se comporten aparentemente como seres humanos han dado lugar al surgimiento de dos bloques enfrentados: el enfoque simbólico o top-down, conocido como la IA clásica y el enfoque subsimbolico llamado a veces conexionista.

Los simbólicos simulan directamente las características inteligentes que se pretenden conseguir o imitar y lo mejor que también se tiene a la mano es el hombre; para los constructores de los sistemas expertos resulta fundamental la representación del conocimiento humano donde gracias a estos avances se han encontrado dos tipos de conocimiento: conocimiento acerca del problema particular¨ y ¨conocimiento a cerca de cómo obtener mas conocimiento a partir del que ya tenemos¨. El ejemplo más representativo de esta corriente es el proyecto de Cyc de Douglas B. Lenat sobre un sistema que posee en su memoria millones de hechos interconectados.

Dentro de la otra corriente: la subsimbolica; sus esfuerzos se orientan a la simulación de los elementos de mas bajo nivel dentro de los procesos inteligentes con la esperanza de que estos al combinarse permitan que espontáneamente surja el comportamiento inteligente. Los ejemplos mas claros que trabajan con este tipo de orientación son las redes neuronales y los algoritmos genéticos donde estos sistemas trabajan bajo la autonomía, el aprendizaje y la adaptación, conceptos fuertemente relacionados.

Uno de los grandes seguidores de la IA; Marvin Minsky, ha dado una clasificación para los lenguajes de programación que se utilizan en esta disciplina:

Marvin Minsky

· ¨Haga ahora¨: Donde el programador surte de instrucciones a la maquina para realizar una tarea determinada donde todo queda especificado excepto quizás él numero de repeticiones.

· ¨Haga siempre que¨: Aquí se permite escribir un programa que le sirva a la computadora para resolver aquello problemas que el programador no sabe resolver pero conoce que tipo de soluciones se pueden intentar.

· "De constreñimiento": se escriben programas que definen estructuras y estados que se condicionan y limitan recíprocamente.

Pero Minsky, admite que aún será necesario desarrollar dos tipos de lenguajes más para obtener una IA comparable a la inteligencia humana; y estos podrían ser.

o "Haga algo que tenga sentido¨: Donde se permite al programa aprender del pasado y en una nueva situación aplicar sus enseñanzas.

o "Mejórense a sí mismo": Allí se podrá permitir escribir programas que tengan en adelante la capacidad de escribir programas mejores que ellos mismos.

Otro punto desde luego tiene que ver con el tema que aquí estamos tratando es por supuesto el concepto de lo que es creatividad , que a simple vista es algo que no podemos explicar porque es resultado de un don especial pero que los estudios sobre IA han comenzado hacer posible dar explicación satisfactoria: nos dicen que en la medida que se logre escribir programas que exhiban propiedad, en esa misma medida se empezara a explicar la creatividad.

Otra propiedad que se espera ver asociada a la IA es la autoconciencia; que de acuerdo con los resultados de las investigaciones psicológicas hablan por una parte de que como es bien sabido, el pensamiento humano realiza gran cantidad de funciones que no se pueden calificar de conscientes y que por lo tanto la autoconciencia contribuye en cierto sentido a impedir el proceso mental eficiente; pero por otro lado es de gran importancia poder tener conocimiento sobre nuestras propias capacidades y limitaciones siendo esto de gran ayuda para el funcionamiento de la inteligencia tanto de la maquina como del ser humano.

Pero seria imposible tratar de contemplar el tema de la IA sin recurrir a la cuestión de la complejidad; donde el comportamiento inteligente es el resultado de la interacción de muchos elementos y que con seguridad es una de las más valiosas contribuciones al tratar de simular en la maquina los fenómenos intelectuales humanos.

La IA se ha desarrollado como disciplina a partir de la concepción de la inteligencia que se realizo al interior de la psicología y a partir de la cual se elaboraron diferentes categorías.

La inteligencia: Diferentes teorías y definiciones.

En 1904 el ministerio de instrucción publica de Francia pidió al psicólogo francés Alfred Binet y a un grupo de colegas suyos que desarrollan un modo de determinar cuales alumnos de la escuela primaria corrían el riesgo de fracasar para que estos alumnos reciban una atención compensatoria. De sus esfuerzos nacieron las primeras pruebas de inteligencia. Importadas a los EEUU varios años después las pruebas se difundieron ampliamente así como la idea de que existiera algo llamado " inteligencia" que podía medirse de manera objetiva y reducirse a un numero o puntaje llamado " coeficiente intelectual" desde entonces sé a definido la inteligencia en términos de "habilidad para resolver problemas".

I.INTELIGENCIAS MULTIPLES

Un psicólogo de Harvard llamado Howard Garden, señalo que nuestra cultura había definido la inteligencia de manera muy estrecha y propuso en su libro " estructura de la mente", la existencia de por lo menos siete inteligencias básicas:

· Inteligencia lingüística: capacidad de usar las palabras de modo efectivo (ya sea hablando, escribiendo, etc). Incluye la habilidad de manipular la sintaxis o escritura del lenguaje, la fonética o los sonidos del lenguaje, la semántica o significado de lenguaje o división, pragmática o los usos prácticos.

· Inteligencia lógico matemática: capacidad de usar los números de manera efectiva y de razonar adecuadamente (pensamiento vertical).

· Inteligencia espacial: la habilidad para percibir la manera exacta del mundo visual-espacial y de ejecutar transformaciones sobre esas percepciones (decorador, artistas, etc).

· Inteligencia corporal – cinética: la capacidad para usar el cuerpo para expresar ideas y sentimientos y facilidad en el uso de las propias manos para producir o transformar cosas.

· Inteligencia musical: capacidad de percibir, discriminar, trasformar y expresar las formas musicales.

· Inteligencia interpersonal: la capacidad de percibir y establecer distinciones entre los estados de ánimo, las intenciones, motivaciones, sentimientos, de otras personas.

· Inteligencia intrapersonal: el conocimiento de sí mismo y la habilidad para adaptar las propias maneras de actuar a partir de ese conocimiento.

Más allá de la descripción de las inteligencias y de sus fundamentos teóricos hay ciertos aspectos que convienen destacar:

o Cada persona posee varios tipos de inteligencias.

o La mayoría de las personas pueden desarrollar cada inteligencia hasta un nivel adecuado de competencia.

o Las inteligencias por lo general trabajan juntas de manera compleja, ósea, siempre interactúan entre sí para realizar la mayoría de las tareas se precisan todas las inteligencias aunque en niveles diferentes hay muchas maneras de ser inteligentes en cada categoría.

Inteligencia emocional: existe una dimensión de la inteligencia personal que está ampliamente mencionada aunque poco explorada en las elaboraciones de Gadner: el papel de las emociones.

Daniel Goleman; toma este desafío y comienza a trabajar sobre el desarrollo de Gadner llevando a un plano más pragmático y centrado en las emociones como foco de la inteligencia.

FUTURO DE LA IA.

El empleo de la IA esta orientado a aquellas profesiones que, ya sea por lo incomodo, peligroso o complicado de su trabajo necesitan apoyo de un experto en la materia. Las ventajas que trae el disponer de un asistente artificial no son mas que las de solucionar los errores y defectos propios del ser humano; es decir, el desarrollo de sistemas expertos que hoy en día se están utilizando con éxito en los campos de la medicina, geología y aeronáutica aunque todavía están poco avanzados en relación con el ideal del producto IA completo.

Técnicas y campos de la Inteligencia Artificial:

· Aprendizaje Automático (Machine Learning)

· Ingeniería del conocimiento (Knowledge Engineering)

· Lógica difusa (Fuzzy Logic)

· Redes neuronales artificiales (Artificial Neural Networks)

· Sistemas reactivos (Reactive Systems)

· Sistemas multi-agente (Multi-Agent Systems)

· Sistemas basados en reglas (Rule-Based Systems)

· Razonamiento basado en casos (Case-Based Reasoning)

· Sistemas expertos (Expert Systems)

· Redes Bayesianas (Bayesian Networks)

· Vida artificial (Artificial Life). La VA no es un campo de la IA, sino que la IA es un campo de la VA.

o Computación evolutiva (Evolutionary Computation)

o Estrategias evolutivas

o Algoritmos genéticos (Genetic Algorithms)

· Técnicas de Representación de Conocimiento

o Redes semánticas (Semantic Networks)

o Frames

· Vision artificial

· Audicion artificial

· Lingüística computacional

· Procesamiento del lenguaje natural (Natural Language Processing)

· Minería de datos (Data Mining)